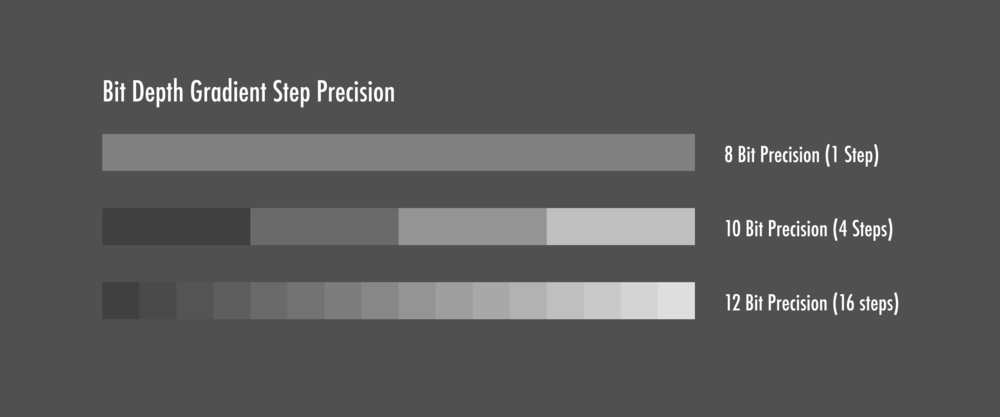

Dolby Vision es 12 Bits, HDR10 como bien dice son 10 bits, y HDR10+ seguiran siendo 10 bits, pero dinamicos, ¿Que implica esto?, pues que afecta directamente a escenas con degradados, donde mas suele apreciarse esto es en escenas donde hay cielo y sol al lado, el sol generalmente creara degradados con banding al rededor de el en HDR10, mientras que el DV al tener 12 bits, esos degradados son muchisimo mejores:

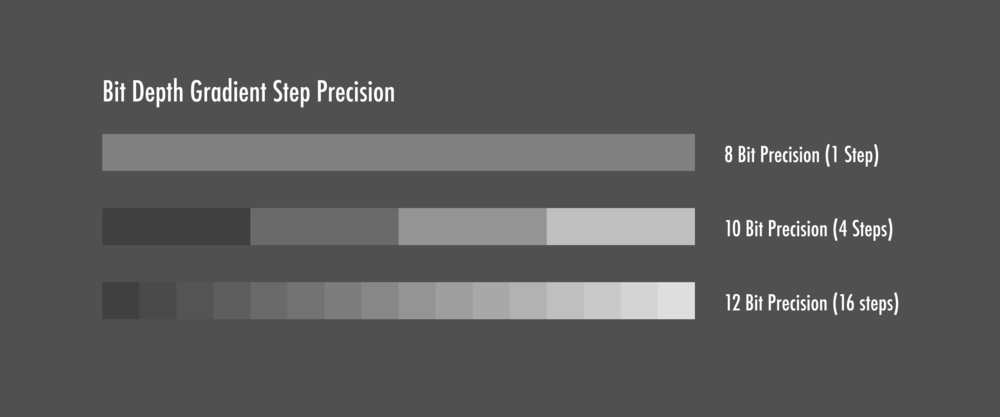

Como podeis ver hablamos de una diferencia de 1 billon de tonos del HDR10, a 67 del DV, o explicado de manera mas simple con otra imagen:

¿Que el HDR10+ puede que llegue a ser de igual calidad (En dinamismo me refiero) que el Dolby Vision? Por supuesto, por eso se ha diseñado como un standard abierto con la intencion de intentar igualar a Dolby Vision, sin pagarles ni un duro, que es por lo que Samsung ha creado esto, para ahorrarse pagar derechos de uso, pero esto tambien implica que sigues teniendo solo 10 bits para representar la imagen, y que entre los 12 y los 10, la diferencia a la hora de tonalidades (Como ya he mencionado en varias ocasiones como bien recordareis "¡Que colores!" "¡Se ve muchisimo mas realista, los colores destacan una barbaridad!"), Dolby Vision siempre llevara la ventaja en este aspecto, simplemente por que Samsung y Panasonic son muy tacaños para pagar por el chipset a Dolby

¡Bienvenido a mundodvd! Regístrate ahora y accede a todos los contenidos de la web. El registro es totalmente gratuito y obtendrás muchas ventajas.

¡Bienvenido a mundodvd! Regístrate ahora y accede a todos los contenidos de la web. El registro es totalmente gratuito y obtendrás muchas ventajas.

LinkBack URL

LinkBack URL About LinkBacks

About LinkBacks

Citar

Citar

MI NUEVO SALÓN 5.1®️

MI NUEVO SALÓN 5.1®️